Klassische Bildverarbeitungslösungen sind sehr leistungsfähig und bieten zum Beispiel hohe Auflösungen und schnelle Verarbeitungsgeschwindigkeiten. Sie können einzelne Teile gut mit einer vorgegebenen Geometrie vergleichen und liefern dabei sehr gute Erkennungsquoten. Typische Anwendungen solcher Systeme finden sich etwa in der Fertigung zur Inline-Qualitätskontrolle. Aber mit anderen Aufgaben, die auf den ersten Blick einfach erscheinen, sind solche Lösungen überfordert, weil sie sich nicht formal bzw. mathematisch beschreiben lassen. Ein typisches Beispiel ist die Erkennung einer Hand. Zur Faust geballt, einzelne oder alle Finger ausgestreckt, mit der Handfläche nach oben oder unten, rechte oder linke Hand – die möglichen Bilder sind so unterschiedlich, dass sie mit einer auf Algorithmen basierten Bildverarbeitung nicht mit ausreichender Sicherheit als Hand erkannt werden können.

Werker-Assistenzsystem mit KI

Das für die eigene Produktion im ifm Werk in Tettnang entwickelte Werker-Assistenzsystem mate stellt aber genau diese Anforderung. Über eine Kamera, die oberhalb des Arbeitsplatzes montiert ist, soll das System die Hand detektieren, um zu erkennen, ob der Mitarbeiter in eine bestimmte Box gegriffen hat. Zum Einsatz kommt hier eine auf neuronalen Netzen basierende Technologie der Künstlichen Intelligenz (KI). Mit einem Deep-Learning-Ansatz erreicht das System eine beeindruckend hohe Erkennungssicherheit. Ob der Werker Rechts- oder Linkshänder ist, spielt dabei ebenso wenig eine Rolle wie die Haltung der Hand. Das Assistenzsystem kommt durch die optische Handerkennung ohne zusätzliche Hilfsmittel, wie VR-Brillen oder Tracker am Handgelenk aus

Vom AGV zum AMR

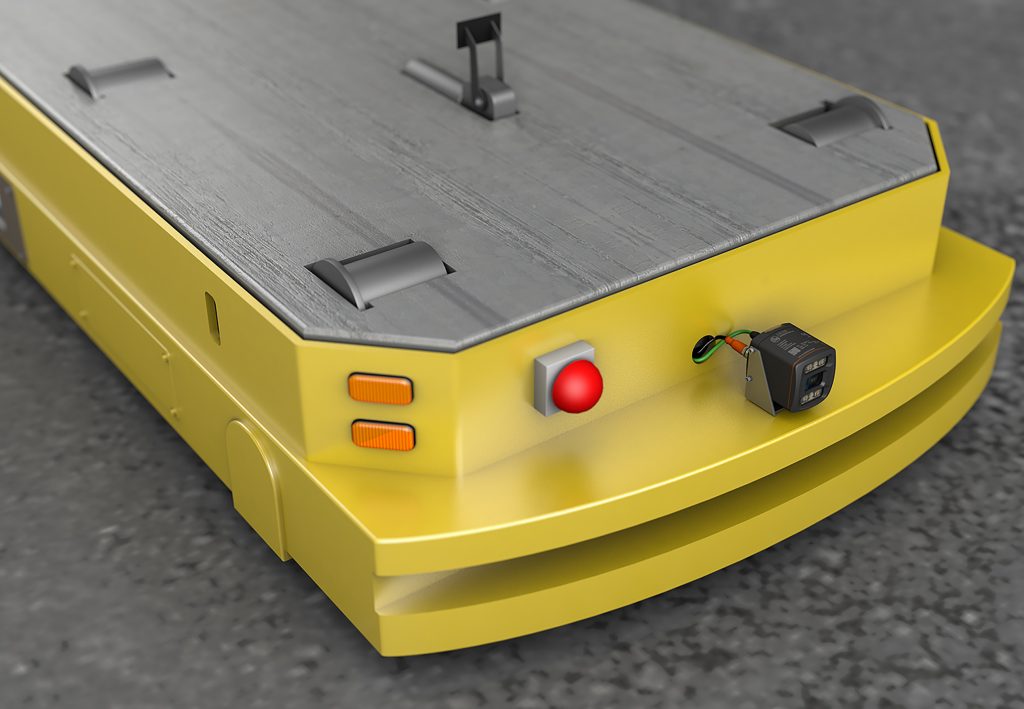

Für diesen Ansatz des maschinellen Lernens in der Bildverarbeitung gibt es zahlreiche weitere potenzielle Applikationen. Einer der größten Wachstumsmärkte für 3D-Bildverarbeitung, die neben dem Bild auch Abstandsinformationen für jedes Pixel ermittelt, ist die Intralogistik. Automated Guided Vehicles (AGV) oder auch Fahrerlose Transportfahrzeuge sind bereits weit verbreitet und bieten enorme Potenziale für Flexibilisierung und Effizienzsteigerung in Logistik- und Produktionsanwendungen. AGVs arbeiten mit einer Vielzahl unterschiedlicher Sensoren, die es ihnen ermöglicht, sich auf vorgegebenen Routen beispielsweise innerhalb einer Lagerhalle zu bewegen. Zusätzlich ist standardmäßig eine Kollisionsüberwachung installiert, die in der Regel auf einem Laserscanner basiert. Dieser überwacht den Bereich in Fahrtrichtung etwa 10cm über dem Boden und stoppt das AGV, wenn es ein Hindernis auf dem geplanten Weg erkennt. Unfälle werden so wirkungsvoll vermieden, und die AGVs können auch in Umgebungen eingesetzt werden, in denen sich Personen aufhalten könnten. Diese auf Laserscannern basierende Kollisionsüberwachung hat allerdings auch Einschränkungen: Typisches Beispiel ist ein Gegenstand, der aus einem Regalfach herausragt. Da der Laserscanner nur den Bereich nah am Boden überwacht, kann er solche Hindernisse nicht erkennen. Eine 3D-Kamera wie die O3D von ifm kann hier deutlich mehr Informationen liefern und damit auch die Hindernis-Erkennung verfeinern.

Mit 3D-Kameras und den genannten Methoden der KI lässt sich auch der Weg in Richtung zunehmende Autonomie beschreiten. Aus AGVs werden AMRs (Autonomous Mobile Robot) mit deutlich umfangreicheren Fähigkeiten. Eine typische Anwendung ist etwa die Palettenerkennung für autonome Gabelstapler. Der Gabelstapler navigiert dabei mit den beschriebenen Methoden bis zu der Position, an der er eine Palette aufnehmen soll. Die genaue Positionierung der Gabel ist dann eine sehr anspruchsvolle Aufgabe, die ifm mit der O3D-Kamera gelöst hat, die etwas oberhalb und zwischen den Gabelzinken montiert ist. Wenn sich der Gabelstapler auf eine bestimmte Entfernung an die Palette angenähert hat, nimmt die 3D-Kamera ein Bild auf und wertet es direkt aus. Als Ergebnis liefert das System die Koordinaten der Palette in x-, y- und z-Richtung sowie eventuelle Verdrehungen um die Vertikalachse oder horizontale Verkippungen. Bei diesem Pallet Detection System (PDS) arbeitet die Bildverarbeitung direkt in der Kamera. Damit verfolgt ifm eine Strategie, bei der viele Funktionalitäten direkt in der Edge erledigt werden. Diese Architektur eignet sich besonders bei fest vorgegebenen Anwendungsfällen, für die dann die passenden Funktionalitäten im Edge-Gerät zur Verfügung gestellt werden. Der Anwender bzw. Systemintegrator muss in diesem Fall keine weitere Softwareentwicklung betreiben.

KI-Funktionalitäten in der Edge

Deep Learning und andere KI-Ansätze lassen sich auch verwenden, um eine verbesserte Orientierung der AMRs im Raum zu realisieren. Durch das dazu verwendete Verfahren, Simultaneous Localization and Mapping (Slamming), weiß der AMR, wie seine Umgebung aussieht und wo er sich innerhalb dieser Umgebung befindet (Localization). Wenn er sich in dieser Umgebung bewegt, kann er zusätzlich eine Karte seiner Umgebung anfertigen (Mapping). Damit simuliert ein solches System genau die Methode, mit der ein Mensch diese Aufgabe löst. Mit unseren Sinnesorganen nehmen wir die Daten aus unserer Umgebung auf, und das neuronale Netz in unserem Gehirn erstellt daraus eine abstrakte Vorstellung einer Karte der Umgebung, in der wir uns bewegen.