Künstliche Intelligenz besitzt großes Potenzial, die Leistungsfähigkeit und Genauigkeit moderner optischer Inspektionssysteme zu verbessern. Herkömmliche KI-Ansätze bergen jedoch einige Nachteile, wie z.B. die Auswertung großer Datensätze, die Notwendigkeit von vorab klassifizierten Bildern, sowie hohe Rechenleistung und Energiebedarf. Sparse Modeling bietet dagegen einen anderen Ansatz und die Integration in Embedded Low-Power-Applikationen. Es ist mittels Re-Training der Systeme direkt am Edge in der Lage, sich kontinuierlich und dynamisch an wechselnde Bedingungen anzupassen, wie z.B. an die Beleuchtung, Vibrationen oder wenn Kameras und/oder Geräte bewegt werden müssen. Im Wesentlichen ist Sparse Modeling ein Ansatz zur Datenerfassung, der sich auf die Identifizierung einzigartiger Merkmale konzentriert. Einfach ausgedrückt interpretiert Sparse Modeling Daten ähnlich dem menschlichen Verstand, anstatt jedes einzelne Haar und jeden Millimeter einer Person zu betrachten. Der Mensch ist in der Lage, Freunde und Familie anhand von Schlüsselmerkmalen – wie Augen oder Ohren – zu erkennen. Sparse Modeling integriert eine vergleichbare Logik in intelligente Visionsysteme mit der Konsequenz, dass nicht das gesamte Volumen an Big Data verarbeitet werden muss, sondern nur wenige ausgewählte Daten. Sparse Modeling-basierte Algorithmen reduzieren folglich die Daten auf diese einzigartigen Merkmale.

Wenn neue Daten erfasst werden, scannt Sparse Modeling nicht den gesamten Inhalt, sondern sucht für die Vorhersagen nach bestimmten, zuvor festgelegten Schlüsselmerkmalen. Ein zusätzlicher Vorteil des Verfahrens ist, dass die isolierten Merkmale für den Menschen verständlich sind. Sparse Modeling erzeugt somit eine erklärbare White Box KI, was ein Unterscheidungsmerkmal zu konventioneller KI ist. Die ersten Entwicklungsphasen eines Modells, in denen die KI-Engine und kundenspezifische Daten zu einem auf den jeweiligen Anwendungsfall zugeschnittenen Modell zusammengeführt werden, basieren dabei vornehmlich auf menschlicher Expertise. Um ein neues Standard-Inferenzmodell zu entwickeln, benötigt Sparse Modeling für die erste Modellerstellung etwa 50 Bilder, was deutlich weniger ist, als die 1.000 oder mehr Bilder, die für eine herkömmliche KI erforderlich sind.

Lauffähig auf Embedded Edge-Geräten

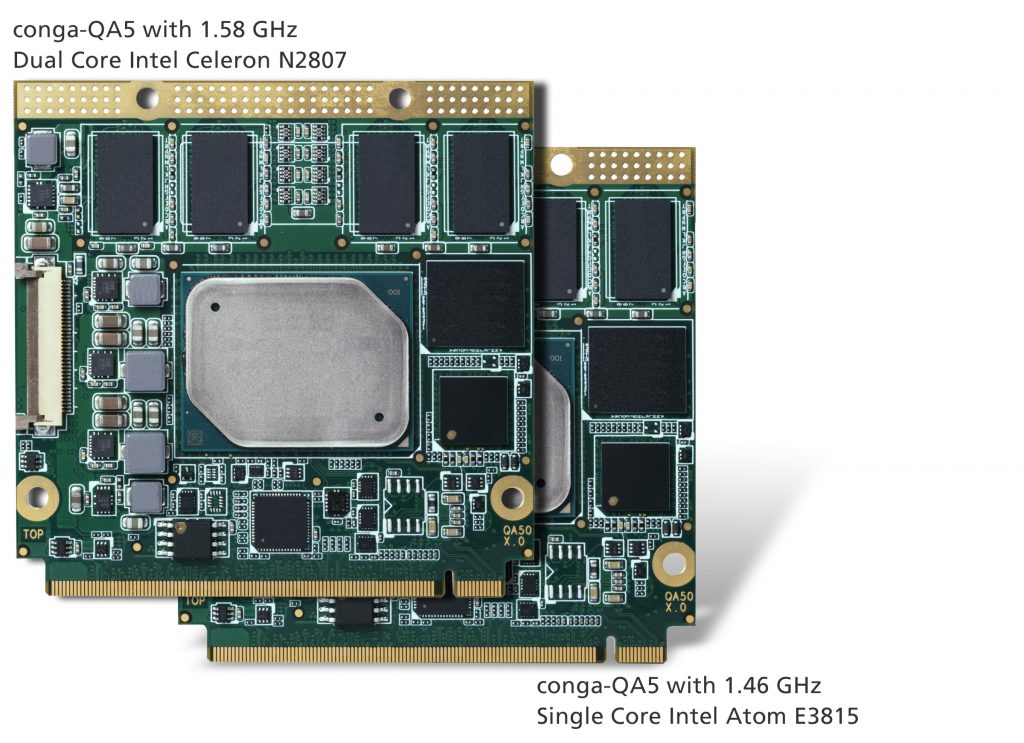

Hardware-technisch kann eine Sparse Modeling-Plattform in praktisch jedes Edge-Gerät integriert werden. Sie kann auf eingebetteten x86-Computerplattformen ausgeführt werden und ist sogar für die Implementierung auf Plattformen wie Xilinx und ARM oder Altera und RISC-V vorbereitet. Das Design ist folglich kompatibel zu Mainstream-x86-Prozessoren als auch zu den aktuellen Open-Source-Lösungen. Da der endgültige Footprint entscheidend von der Aufgabenstellung und Komplexität des benötigten Modells abhängt, empfiehlt sich bei der Einführung von Sparse Modeling folglich eine modulare Hardwareplattform auf Basis von Closed Loop Engineering-fähigen Computer-on-Modulen, die beide Prozessorvarianten bedienen können. Die Präzisionsfertigung profitiert von dieser neuen Technologie, weil die Edge Nodes dank Sparse-Modeling nun genügend Rechenleistung bieten, um Inferenz und Training parallel durchzuführen. Auch wird das Versenden von Daten in die Cloud umgangen. Ein weiteres Anwendungsgebiet ist die Medizintechnik, z.B. bei der Erkennung seltener Erkrankungen, die eben nicht genügend Big Data produzieren, wie sie für die Ausbildung eines Deep Learning-basierten KI-Modells erforderlich wären.

5x schneller und extrem energieeffizient

Die bisher erzielten Erfolge mit Sparse Modeling sind überzeugend: Im Rahmen eines Projekts mit einem Industriekunden wurde ein Vergleich eines Sparse Modeling-basierten KI-Tools und einer konventionellen Deep Learning-basierten Technik durchgeführt. Für die Beispielstudie wurde ein Datensatz bestehend aus 1.000 Bildern von beiden Modellen verwendet, um Vorhersagen zu erstellen. Der Kunde hatte die akzeptierte Modellvorhersagewahrscheinlichkeit mit 90% definiert. Beide Ansätze lieferten vergleichbare Ergebnisse, aber der Aufwand unterschied sich erheblich: Das auf Sparse Modeling basierende Modell wurde 5x schneller trainiert als das auf Deep Learning basierende Modell, obwohl das Sparse Modeling Tool auf einem Standard-x86-System mit Intel Core i5-3470S Prozessor und 16GB RAM ausgeführt wurde. Das Deep-Learning-Modell hingegen benötigte eine Nvidia Devbox-basierte Entwicklungsplattform mit vier Titan X-GPUs bei 12GB Speicher pro GPU, 64GB DDR4-RAM sowie ein Motherboard der Asus X99-E WS-Workstation-Klasse mit vierfach PCIe Gen3 x16-Unterstützung und Core i7-5930K 6 Core 3,5GHz Desktop-Prozessoren. Am Ende verbrauchte der Sparse Modeling-basierte Ansatz nur 1% der Energie, die der Deep Learning-basierte Ansatz benötigte und erzielte dabei die gleiche Genauigkeit.

Nur 50 Bilder erforderlich

Der geringe Speicher- und Performancebedarf macht es OEMs von Visionsystemen leicht, KI zu implementieren. Bestehende Plattformlösungen können meist wiederverwendet werden und die Systemintegration ist relativ einfach, da sich die Logik des Hacarus+ SDK an gängige Bildverarbeitungssysteme anpasst, ohne dazu viel am Setup ändern zu müssen. Während bestehende optische Inspektionssysteme ihre Erstinspektion weiter fortsetzen, kümmert sich die Software nur um die Bilder, die als NIO und somit ´möglicherweise defekt´ identifiziert wurden. Mit etwa 50 oder weniger solcher Bilder kann Sparse Modeling bereits mit dem Aufbau eines neuen Inspektionsmodells beginnen. Sobald das Modell von menschlichen Inspektoren validiert wurde, kann es als zweite Inspektionsschleife neben der bestehenden Plattform laufen und die Inspektionsergebnisse über seine APIs an das System zurückgeben. Eine optionale HTML-basierte Benutzeroberfläche steht für die Prozessüberwachung bereit. Eine solche Logik kann auch eigenständig laufen; da das Preprocessing von Visionsdaten jedoch nicht die Kernkompetenz von Sparse Modeling ist, wird die Anbindung an bestehende Visionslogik empfohlen. Das Sparse Modeling Tool kann als Standardinstallation in der Softwareumgebung des Kunden implementiert werden oder eine per Hypervisor isolierte virtuelle Maschine in einer Cloud nutzen; selbst FPGA-basierte Implementierungen auf applikationsspezifischen Carrierboards sind möglich, um die Leistungsaufnahme weiter zu reduzieren.